type

status

date

slug

summary

tags

category

icon

password

1.安装和配置Ollama

选择对应系统版本安装包

验证安装是否成功:

由于Ollama只能装在C盘,因此模型默认也在C盘,模型多了可能会卡,因此可以利用新建环境变量的方式把模型存在其他文件夹。Ollama 支持通过设置

OLLAMA_MODELS 环境变量来自定义模型存储位置。具体步骤:

- 新建或选择一个目标目录,例如:

D:\ollama-models

- 设置系统环境变量(持久生效):

- 在“系统属性” > “高级” > “环境变量”中,点击“新建”

- 变量名:

OLLAMA_MODELS - 变量值:

D:\ollama-models

- 重启终端(或系统)后再运行:

模型就会被自动下载到你指定的新路径。

载入之后可以通过命令行与模型交互,也可以用Ollama的客户端选择对应模型交互。

具体有哪些模型可以在Download Ollama on Windows这里搜索,并且贴心的给出了模型参数对应的显存大小和运行的命令。

2.python调用本地模型的方式

3.安装AnythingLLM快速构建知识库

安装没啥好说的,下载运行就行。

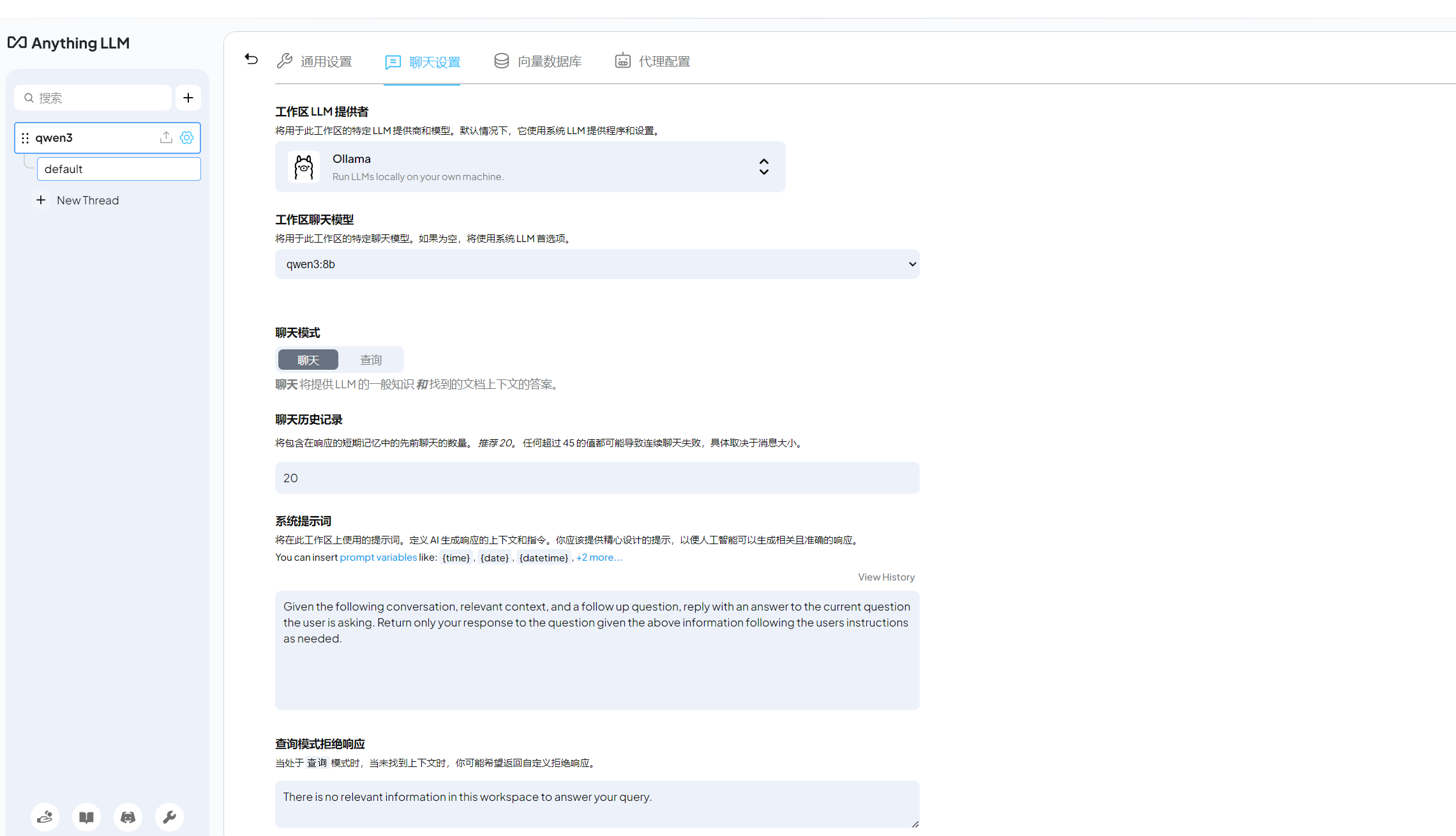

然后先把Ollama部署的Qwen3跑起来,再在AnythingLLM中创建新的工作区,然后在聊天设置里选择Ollama和Qwen3

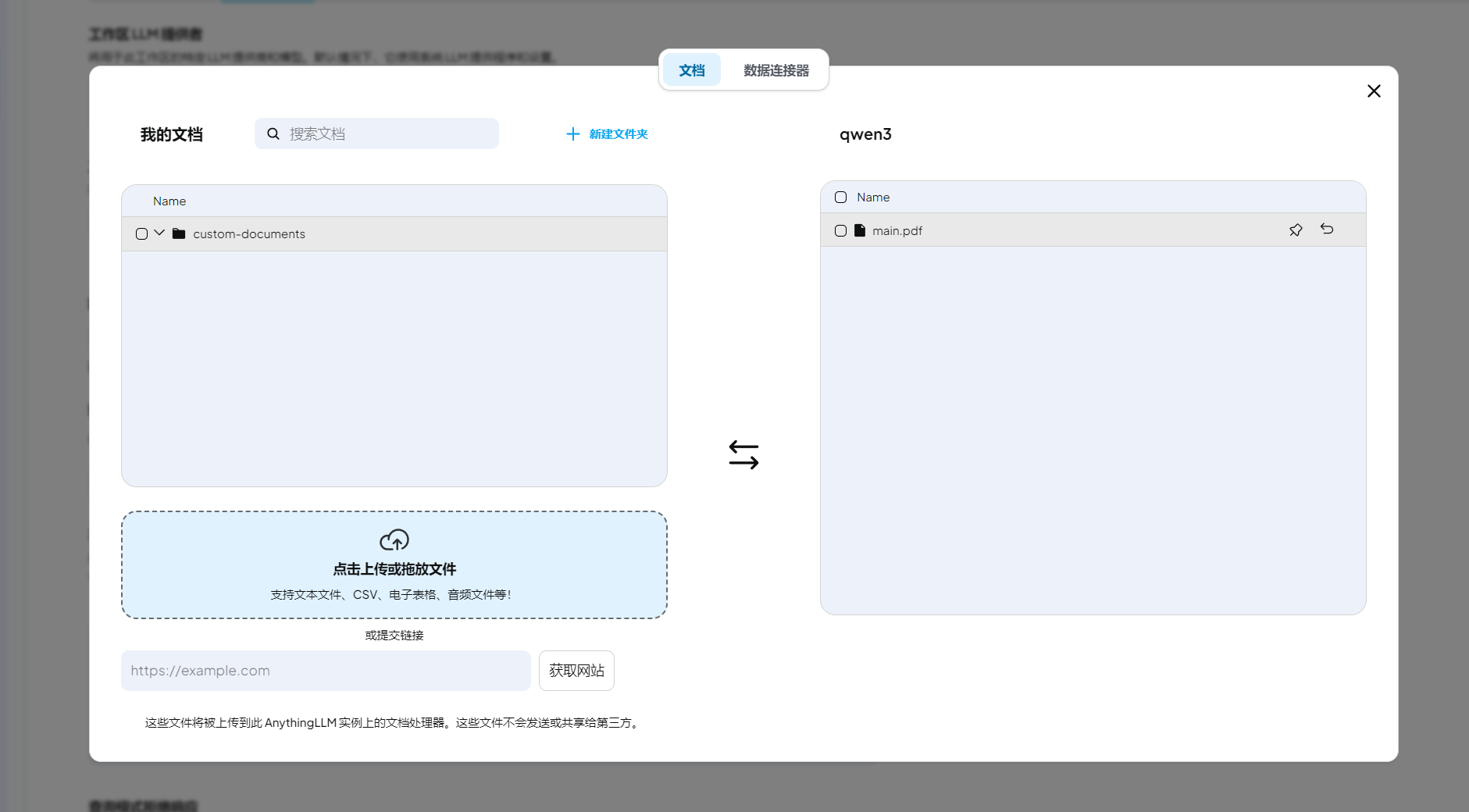

随便上传个文档作为RAG的数据源,然后要移到工作区然后嵌入成向量:

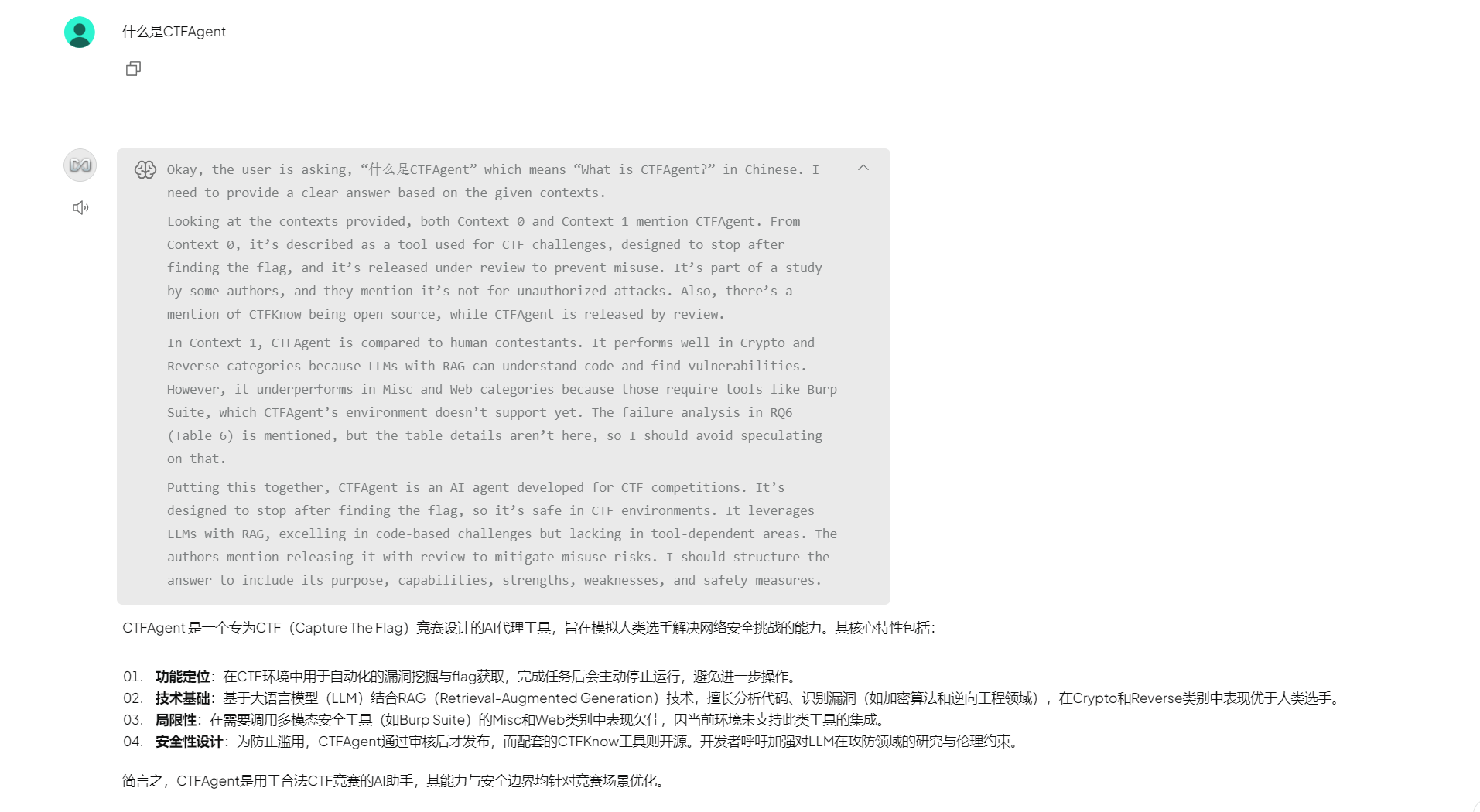

最后开始对话就可以根据我的文档来回答了,这里我上传了朋友的论文:

4.从本地向外拓展

AnythingLLM 还有着向外拓展的强大潜力。它能够将构建好的 RAG 体系作为一个整体,对外提供服务能力。通过生成 API 秘钥与配套的接口文档,允许外部系统与之对接,融入更广泛的应用场景,如企业内部知识共享平台、在线教育辅助工具等,极大地拓宽知识的辐射范围。

说人话就是你本地构造的RAG可以给别人在线使用…

- Author:ZimaBlue

- URL:https://www.zimablue.life/article/Ollama1

- Copyright:All articles in this blog, except for special statements, adopt BY-NC-SA agreement. Please indicate the source!